Meine Vermutung ist das Firefox Scripte von Third Party Domains für lokal gespeicherte Seiten nicht ausführt.

Webseiten analysieren und komplett herunterladen

Zeig doch mal einen Screenshot wie das bei dir lokal aussieht. Hallo, Olli alias Brillenträger? Setze Dir doch einfach ein esezeichen oder verlinke sie af Deinen Desktop wenn sie so wichtig ist. Ansehen konnte ich sie sofort, echt sehenswert auch die Sonne sehr schön, also eindrucksvolle Bilder obwohl ich Java komplett "deaktiviert" habe.

Webseiten komplett downloaden

Und auf einen Stick ziehen geht auch nicht? Ansonsten wäre mein "Ton" nicht so persönlich gewesen. Aber da ich die Webseite sofort ansehen konnte denke ich auch das man sie problemlos auf einen Stick ziehen könnte? Wenn er die gesamte Webseite zurzeit nicht auf die Festplatte abspeichern kann, dann geht das auch nicht auf einen Stick. Auch mit einer schnelleren Internetverbindung, macht es manchmal Sinn etwas zu speichern. Die Inhalte dieser Seiten sind nur für den persönlichen Gebrauch. Jegliche Weiterverwendung und Reproduktion - auch ausschnittsweise - ist untersagt.

Artikel Aktuelle Artikel Artikel-Übersicht Alle Schwerpunkte Newsletter abonnieren Tipps und Tricks Übersicht Foren Forenübersichten Beiträge aller Foren Neue Diskussionen Unbeantwortete Fragen. Aktuelles Allgemeines Nickles Blog Nachhaltigkeit Rundfunkbeitrag Widerstand. Service Private Kleinanzeigen Kritik und Fragen an Nickles. Unterhaltung Off Topic Spiele Konsolen, PC, online, mobil Retrocomputing Fernsehen Smart-TV, Mediacenter, Streaming Bilder des Tages Das Reise-Blog Virtual Reality.

Software Office Word, Excel und Co Anwendungs-Software und Apps Multimedia Programmieren alles kontrollieren.

Seiten aus Chrome speichern, um sie später zu lesen

Betriebssysteme Windows 10 Windows 8 Windows 7 Windows sonstige Android Apple OSX und IOS Linux Alternative Betriebssysteme. Hardware Gebrauchte Computer und Zubehör PC Komplettsysteme Raspberry Pi und Co Mainboards, BIOS, Prozessoren, RAM Grafikkarten und Monitore Audio-Hardware Drucker, Scanner, Kombis PC-Selbstbau, Reparatur, Optimierung Fotografieren und Filmen Datenträger HDD, SSD, DVD und Co Der günstigste PC der Welt. Mobil Kompakte Mobilgeräte Smartphones, Phablets, Watches Laptops, Tablets, Convertibles. Internet ze Internetanschluss und Tarife Internet der Dinge Werbung nein danke Ad- und Script-Blocker Heimnetzwerke WIFI, LAN, Router und Co Download-Dienste und Tauschbörsen Clouds, Datensynchronisation Internet-Software Browser, FTP, SSH Kommunikation Email, Messenger, Telefone, Chats, VOIP Viren, Spyware, Datenschutz Soziale Netzwerke Homepage selbermachen Server für LAN und Internet.

Antwort absenden bei Antwort benachrichtigen. Danke für den Tipp. Aber wie oben erwähnt habe ich es mit dem Programm bereits versucht. Hier ist mal ein Screenshot von der Seite, wie sie normalerweise aussieht: Das vermittelt aber nur einen sehr schwachen Eindruck davon, wie genial die 3D-Ansicht ist, in der man sich frei bewegen kann, vom Inneren des Sonnensystems bis an den Rand der Galaxis.

HTTrack | Download bei heise

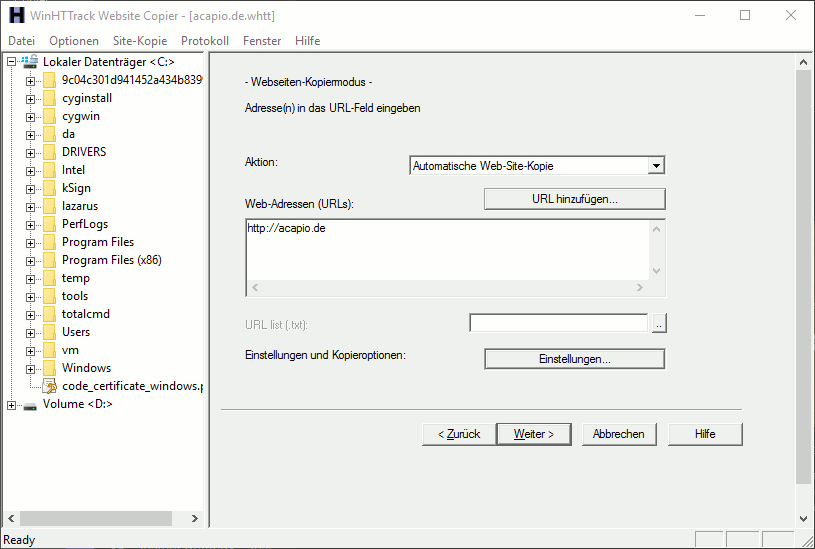

Der Ordner auf meiner Festplatte enthält dann lediglich 37 JScript-Dateien, ein Stylesheet, eine css-Datei und ein GIF-Bild zus. Im Browser habe ich Java- und Flash-Inhalte sowie Cookies für die Seite freigegeben. Mein Lieblingstool nennt sich HTTrack und funktioniert in vielen Fällen mit den Grundeinstellungen super und erzeugt eine wirklich gute Kopie von Internetseiten auf dem lokalen PC. Zudem bietet HTTrack noch zahlreiche Einstellungen über welche genau definiert werden kann, welche Files gespeichert werden sollen.

So ist es z. Zudem ist es auch möglich lokal gespiegelte Internetseiten immer wieder auf den aktuellsten Stand zu bringen! HTTrack gibt es für alle gängigen Betriebssysteme wie z. Windows, Linux, Sun Solaris und weitere Unix Systeme.

WinHTTrack - Webseiten spiegeln

Zusätzlich steht auch noch eine portable Version für Windowssysteme zur Verfügung. Schritt 1: HTTrack herunter laden kostenloser Download von HTTrack. Schritt 3: Basisdaten hinterlegen Zuerst werdet ihr hier nun gefragt, welchen Namen das Projekt bekommen soll und wo die Internetseite auf Eurem PC gespeichert werden soll.

URL der zu speichernden Webseite angeben und falls diese einen Passwortschutz hat, die Zugangsseiten der Internetseite hinterlegen. Ob alles gesichert werden soll, nur bestimmte Verzeichnisse oder nur z.

Wobei HTTrack auch abgebrochene Aufträge zu einem späteren Zeitpunkt wieder aufnehmen kann. So sieht nach dem Download das Verzeichnis aus in welchem sich die Daten befinden!

Hier müsst ihr nun einfach einen Doppelklick auf die index. So einfach ist es Webseiten zu rippen und diese für eigene Zwecke zu archivieren! Wer mit diesem Tool nicht klar kommen sollte, der kann sich auch noch meinen zweiten Tool-Tipp etwas näher ansehen! Im Prinzip ist die Bedienung dieses Crawlers genau so einfach wie die des oben vorgestellten Tools. Jedoch habe ich bemerkt, dass das HTTrack bessere Ergebnisse liefert als der Xaldon WebSpider! Jedoch bietet dieses Tool eine Option welche für bestimmte Personengruppen vielleicht ganz nützlich ist!

Der WebSpider besitzt auch die Funktion Links und Emailadressen zu grabben und diese getrennt auszugeben. Gut, was man mit solchen Informationen anstellen kann, hat nichts mit dem speichern einer Webseite zu tun! Daher möchte ich auch hier nicht näher darauf eingehen! Kommen mir also zur Anleitung….

- pokemon gold runterladen.

- Website Ripper Copier!

- Ähnliche Beiträge?

- Sie wollen schon gehen??

- win 10 pro herunterladen.

- ipad apps runterladen geht nicht.

- curse client deutsch download.

Schritt 1: Xaldon WebSpider herunter laden und installieren kostenloser Download Xaldon WebSpider. Schritt 3: Basisdaten hinterlegen Im Fenster 1, wird nun die URL und der Projektname hinterlegt. Fall die Webseite geschützt ist, muss dieses Fenster aktiviert werden. Danach könnt ihr die Zugangsdaten eingeben. Hier könnt ihr nun einstellen, ob ihr die Emailadressen auf der Webseite speichern wollt und Euch der Spider auch alle fehlerhaften Links auflisten soll. Hier könnt ihr nun die Ebenen definieren, wie Tief der Crawler noch die Webseiten auslesen soll und darf.

Mittels Auswahlfenster wird dann festgelegt, welche Dateien geladen werden dürfen und wie das Programm vorgehen soll. Hier wird hinterlegt, wo sich die Dateien befinden dürfen, welche geladen werden sollen. Manchmal werden z. Dann müssen hier die Einstellungen geändert werden. Gerade eingestellte Daten speichern?

Dies würde ich empfehlen! Man kann ja nie wissen!